Olá, pessoal. Tudo bem?

Estou fazendo um trabalho para faculdade e utilizei algumas séries do site: http://www14.fgv.br/fgvdados20/default.aspx?Convidado=S

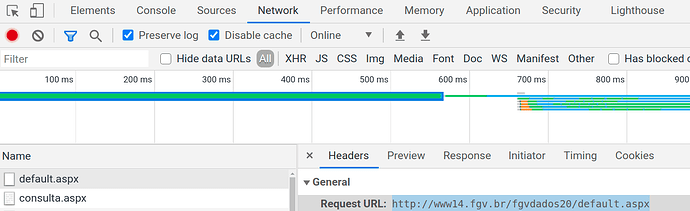

No site, eles dão a opção de baixar a série em formato XLS. No entanto, como a url não muda e não encontrei o arquivo .xls na opção de inspercionar, recorro aqui a ajuda de vocês.

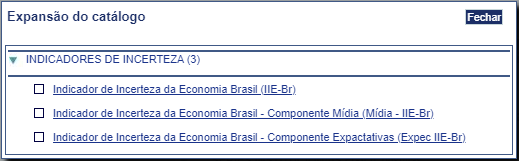

Pois bem, a ideia seria navegar pelo R, de modo a baixar o arquivo XLS da série de “Indicadores de Incerteza”. Para tanto, a seguinte ordenação de passos deve ser estabelecida:

-

Acessar o site http://www14.fgv.br/fgvdados20/default.aspx?Convidado=S

-

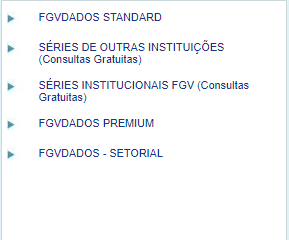

Clicar no triângulo ao lado de "Séries Institucionais FGV (Consultas Gratuitas)

-

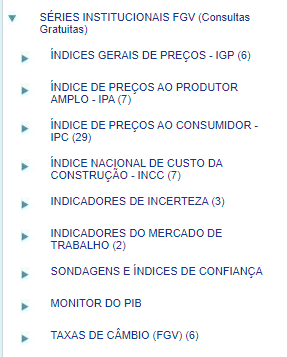

Em seguida, clicar no triangulo ao lado de “Indicadores de Incerteza”

-

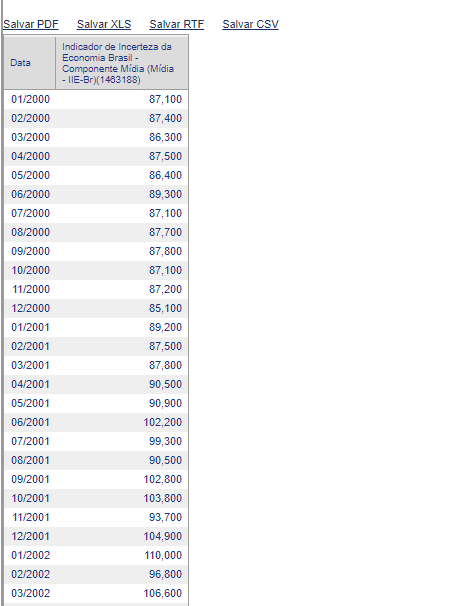

Marcar a opção de "Indicador de Incerteza da Economia Brasil (IIE-Br)

-

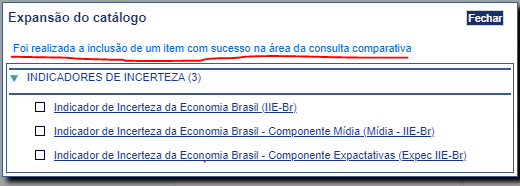

Clicar em “Fechar”

-

Clicar em “Série histórica” e, em seguida, “Visualizar e salvar” .

Nesse ponto a série em questão aparece em uma tabela e na parte superior lhe da a opção de salvar em diversos formatos. Qualquer um deles é últil pois permite o tratamento no R.

Então, minha dúvida é a seguinte:

-

Será que preciso criar um script que “navegue” por esses passos até conseguir baixar ou capturar a tabela? Ou será que na inspeção existe algum link “escondido” que já me leve diretamente para a série de dados?

-

Como fazer isso no R? Não sei nem por onde começar, rs.

Como sempre, agradeço demais a ajuda de vocês e parabenizo pela iniciativa do fórum.